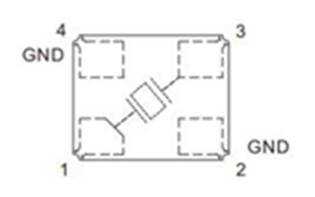

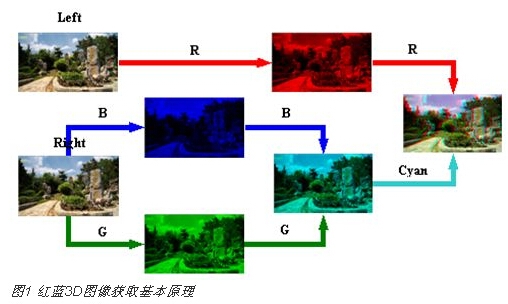

现在,3D显现已逐步融入到人们的日子傍边,因其能再现实在的三维场景,受到了人们的广泛酷爱,红蓝3D图画获取的根本原理如图1所示。摄像头收集同一场景的两路视频图画信号,对其间一路信号只提取图画信号的赤色重量;另一路提取图画信号的蓝、绿色组成的青色重量。将两路信号选用同步色差组成算法组成红蓝3D视频图画。现在国内3D电视工业面对的首要问题在于:(1)3D电视芯片的短少而导致3D片源的短少;(2)视频处理的杂乱度较高;(3)显现与观看作用欠安。为此本文对传统的视频处理进程中色度重量的提取、亮度的增强、红蓝3D眼镜的规划等方面进行了改善,并选用LCOS作为微显现器材,投影出红蓝3D视频图画。

1 色彩重量的获取与亮度的增强

传统的办法只选用红加蓝、红加绿色度重量组成3D视频,这样会使画面的损害较大,丢掉33%以上的色彩重量,观看起来色彩失真较大,亮度也大大下降,增加了眼睛的担负,易发生疲惫。针对色彩失真本文选用红加青的办法以削减色度的丢掉,这样可使画面色度饱和度复原到原始画面的90%以上。

针对亮度下降提出了根据亮度的图画增强办法。传统的根据Retinex理论的演变法存在必定的缺乏,如将RGB空间转化到HSI空间需求很多的三角函数运算,并选用傅里叶改换处理Retinex理论部分的高斯函数,大大影响处理速度。本文提出了根据YCbCr色彩空间的亮度重量处理法,一起选用无限脉冲响应数字滤波器(IIR)完成高斯函数运算。试验证明,该算法不但能增强图画的质量,还能有用防止Retinex算法中带来的光环效应,一起大大加速算法处理速度。根据亮度Y重量的Retinex 处理进程可表明为:

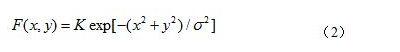

式中Y( x , y)为亮度重量函数,F( x , y) 被称为环境函数,一般用高斯函数表达式为:

σ为高斯函数的规范偏差,k 表明环境函数的个数。环境函数Fk用于选取不同的规范偏差σk,Wk用来操控环境函数规模的规范,它表明与Fk相关的权重系数。

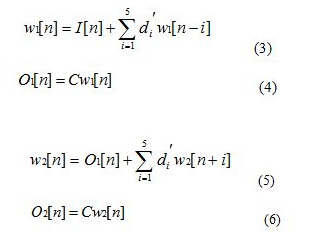

Retinex 处理算法的首要进程便是高斯滤波,其运算速度直接决议了算法运转功率。为防止傅立叶改换的杂乱的运算和缺乏,对高斯滤波器进行了IIR完成,把高斯滤波器分解为正向滤波器和反向滤波器的组合,如下面的差分方程。

正向滤波器:

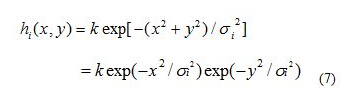

其间,C、di’是滤波器系数,I [n]是输入数据,w1 [n]和w2 [n] 别离是正向和反向滤波器的中间状态,O1[n]、O2 [n]为其处理成果。正向和反向滤波器就构成了高斯滤波器的IIR完成进程。能够使用高斯函数的可别离性:

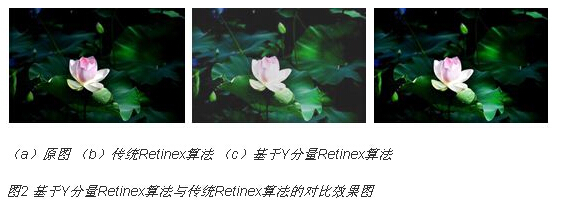

对图画先逐行后逐列进行处理,终究就能够完成二维高斯数字滤波。下图2为原图、传统Retinex算法、根据Y重量Retinex算法处理后的比照图。图中能够看出,传统算法能够增强图画亮度,但灰度化也很明显。而本文选用的办法不只能够增强亮度,也能够坚持原有图画的全体艳丽作用。

别的,传统的3D眼镜仅选用赤色或蓝色塑料或玻璃镜片作为滤光片,使滤光作用大打折扣,观众佩带观看影片时,会呈现不同程度的重影现象,影响观看作用。为此本文选用反射率和透过率都到达90%以上的反青透红和反红透青的滤光片作为3D眼镜的镜片,这样能够使赤色镜片仅经过赤色画面,青色镜片透过蓝、绿色画面,消除了重影现象,使观看作用愈加鲜活、传神,下图3为滤光片及制造的红蓝3D眼镜。

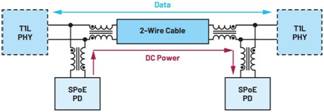

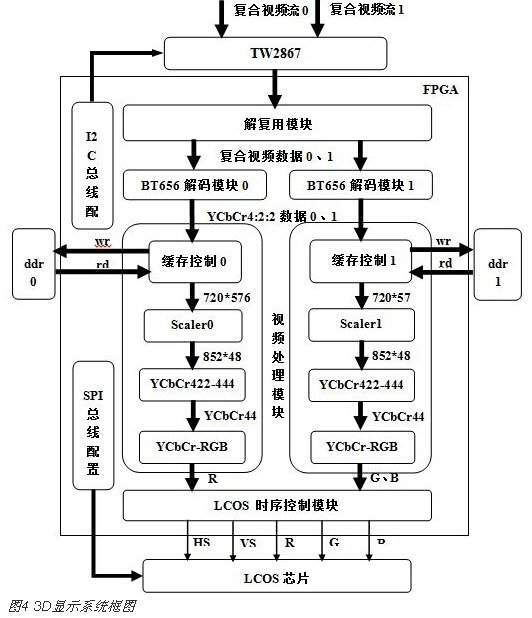

2 视频处理体系根本结构与简化

整个视频处理体系结构如图4所示。两路摄像头将收集到的信号送入TW2867进行A/D转化,输出的复用信号送入解复用(demux)模块,别离出的两路复合视频数据别离送入BT656数据解码模块、帧缓存操控模块、像素分辨率缩放模块、YCbCr 4:2:2转YCbCr 4:4:4数据模块、YCbCr亮度增强模块、YCbCr 4:4:4转RGB数据模块,最终将RGB数据送入LCOS时序操控模块,以镁光公司的CS-FLCOS作为微显现器材,建立光机体系,显现出3D视频画面。对其间的TW2867芯片和LCOS芯片别离要进行I2C总线装备和SPI总线装备其内部的相关寄存器参数。

(1)TW2867解码

选用带有LED夜视功用的Sony CCD 感光芯片摄像头,视频输出分辨率为720*576,为规范的PAL制式视频格局。选用Techwell公司的TW2867 A/D转化芯片,能自动识别PAL/NTSC/SECAM格局的2路复合视频信号,经过I2C总线的装备,TW2867将两路摄像头信号转化为契合BT656规范的8位YCbCr数字信号。TW2867每一路都含有10位的ADC转化器、高质量的钳位和增益操控器和梳状滤波器,以滤除信号中的噪声,一起选用了一些图画增强技能,以取得高质量的YCbCr数字信号。

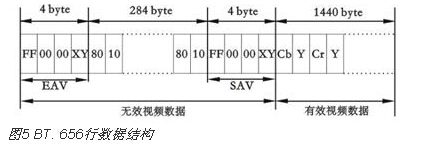

(2)BT656数据解码模块

世界电信联盟无线电通信组(ITU-CCIR)发布了ITU-BT656的视频规范,其行数据结构如图5所示。该模块首要需求检测数据流中是否按序呈现了FF、00、00的帧头SAV或帧尾EAV信息。假如呈现则对后8位的XY值进行判别,判别是否呈现SAV、EAV信号,将有用视频信号的以亮度重量(Y)作为高8位,以色度重量(Cb或Cr)作为低8位组成16位的YCbCr数据,将BT656数据奇偶场的数据合并为一帧写入帧缓存中。

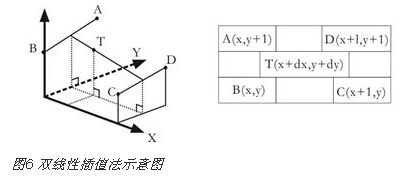

(3)像素分辨率缩放模块

(3)像素分辨率缩放模块帧缓存中装载的是两场视频数据,在读取的时分选用FIFO缓存并选用双线性插值算法,将本来720*576的像素分辨率扩大到852*480。双线性插值算法将在水平缓笔直两个方向别离进行一次线性插值。其定量核算办法如下:空间坐标系下四个点:A(x,y+1)、B(x,y)、C(x+1,y)、D(x+1,y+1),如图6所示,其灰度值依次为Ga、Gb、Gc、Gd,dx和dy别离表明目标点与点B在水平缓笔直两个方向上的增量,其灰度值Gt能够由其他四点量化表明,如式2-1。

Gt = (1 – dx)(1 – dy)Gb + dx(1 – dy)Gc + (1 – dx)dyGa + dxdyGd (2-1)

从电路完成方面而言,公式(2-1)共需求8个乘法器、2 个减法器和4 个加法器,将会占用较多的逻辑资源。将公式变形为:

Gt = Gb+dx(Gc-Gb)+dy(Ga-Gb)+dxdy(Gb-Ga-Gc+Gd)

= Gb+dx(Gc-Gb)+dy(Ga-Gb)+dxdy[(Gb-Ga)+(Gd-Gc)](2-2)

公式(2-2)是另一种简化了电路的表明办法,仅需求4个乘法器、4 个减法器和3 个加法器。核算成果会有5个时钟周期的延时,当像素时钟为27Mhz,核算的时钟为一帧的数据转化为852*480*(1/27Mhz)=15ms,即能够完成实时的分辨率调整。

(4)YCbCr 4:2:2转YCbCr 4:4:4数据模块

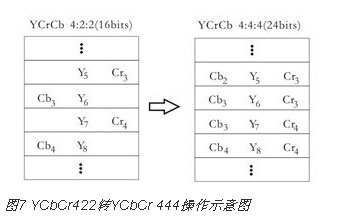

将YCbCr4:4:4数据转化到YCbCr4:2:2是数字视频中的一个选通功用。而将YCbCr4:2:2数据转化到YCrCb4:4:4便是重采样的进程,采样的数据格局改变如图7所示。

可知,输入16位YCbCr转化成了相应各8位Y、Cb、Cr信号,且输出像素采样率比输入采样率快了一倍,由此可见YCbCr4:2:2的数据格局紧缩了将近一半的数据带宽。

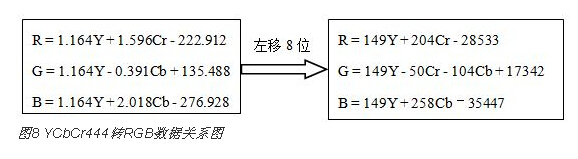

(5)YCbCr444-RGB模块

将YCbCr数据转化为RGB数据可由下图8所示数据联系得到。因为FPGA进行浮点运算较为杂乱,且占用的时钟周期较长(比方16位的浮点加法电路,一般多达十几到二三十个时钟周期),并不适合于实时视频数据处理,所以先经过对上式左右二端扩大128倍化为整数运算,核算后再对成果除以128(右移7位),即可取得正确的成果。

(6)LCOS时序操控模块

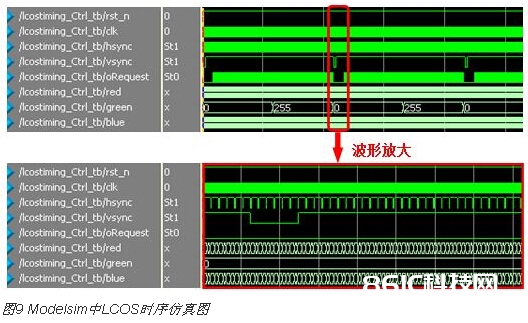

LCOS时序发生器首要用于发生微显现器材所需的时序,包含供给像素时钟(clk)、行同步信号(hsync)、场同步信号(vsync)、有用信号(valid),并输出当时行、列像素坐标值,从帧缓冲区宣布数据恳求信号并读出红、绿、蓝的视频数据。LCOS的时序仿真图如下图9所示。

3 FPGA红蓝3D视频获取及片面点评

FPGA选用的是Altera公司的Cyclone IV系列的EP4CE30F23C6N这款高速FPGA芯片,FPGA和DDR2之间的时钟频率能够到达200M,DDR2内部时钟频率到达400M,充沛满意了两路视频处理的要求。经过对视频处理进程中模块的编写,编译后其耗费的的逻辑单元数为13615个,仅占总逻辑单元数的47%,如下图11所示,使视频处理进程愈加简洁高效。将以上各模块建立、调试、下载到FPGA中,并选用镁光公司的LCOS芯片作为微显现器材,摄像头收集到的《阿凡达》2D电影的一个画面转化为3D换面作用如下图12所示,能够看到图面中的人物具有视差的红蓝两路图画,佩带上红蓝3D眼镜,即可看到人物出屏的作用。

现在针对于3D显现的点评的办法首要仍是片面的点评办法,依照2000年世界电信联盟发布的ITU-R BT.1438立体电视图画片面点评规范,分为5级,即优异、杰出、一般、欠好、坏五个等级。以立体图片上的一点为中心,单眼左右移动时,图画会呈现接连的跳动,两次跳动之间眼睛移动的视点为立体图画的视变角,视角越大,观看越舒适,但视角变大意味着立体感削弱。经过多人观看本文的3D视频,本规划片面点评在杰出等级,到达了预期的规划作用。

4 结束语

本文完成了一种结合Altera公司出产的Cyclone IV系列FPGA的3D视频前端处理与显现体系,具有规划周期短、结构简略、安稳牢靠、完成作用传神、节省规划本钱的长处。高速图画收集体系中选用FPGA作为收集操控部分,不只能够进步体系处理的速度,还能够进步体系的灵活性和适应性。补偿了当时3D电视芯片短少的问题,对原有的视频处理进程及显现器材进行了改善,并提出了一种简洁性和普适性的图画增强算法。该体系在安防监控、倒车印象、图画剖析、影视拍照和投影显现等方面都具有广泛的使用远景。