鲁 冰 (《电子产品世界》修改)

AI(人工智能)在M级的廉价的小器材上能不能落地?它需求什么资源,功用又怎么样?不久前,Arm我国携手恩智浦半导体在全国进行了巡回演说。Arm我国高档商场司理Eric Yang共享了AI的基础知识,剖析以为边际AI能够经过在MCU这样的小芯片上完结,并推介了Arm的软件中心件NN——能够有效地对接算法和详细芯片,最终罗列出了Arm MCU的运用事例。

1 边际AI潜力巨大

AI有没有出路?

前两年AI十分火,AI公司付出的薪水很高。不过,2019年上半年以来,许多AI公司活得并不是很好。AI究竟有没有机会?还需不需求重视?

假如学习前史,大约在5亿年前是单细胞生物,之后生物学上呈现了寒武纪大迸发,产生了许多的新生物,其间带智能的生物渐渐进化出来。

现在从嵌入式或许工业视点来看,有点类似于寒武纪的前夕。假如从身边去调查,会发现无论是日子仍是工作环境安装了许多传感器,并且传感器有越来越多的趋势。Arm的孙正义先生以为,现在仍是百亿级、千亿级传感器的量,到2025年会有约1万亿的设备连上传感器,相当于2025年时到了寒武纪大迸发时期。

不过,那么多传感器相连,假如都靠传统的核算办法,即完全是靠你的算法或操控去完结一些功用/功用的时分,是有很大的瓶颈的。所以许多传感器或许会选用AI技能,一部分AI在云端,更多的是在嵌入式端。

2 AI中遇到的概念

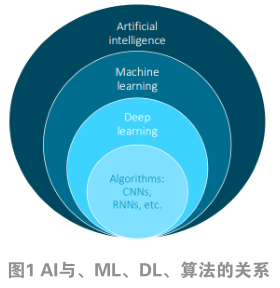

AI、机器学习(ML)、深度学习(DL),这些概念究竟什么联系?

AI是用机器来模拟人的思想习惯,让机器来到达人的决议计划的才干。要完结这一功用,就需求让机器做学习,这主要是经过概率论、计算论之类的办法,让机器找到算法,以完结机器能够学习这样的功用(如图1)。

完结机器学习里边有种办法叫深度学习。深度学习相当于你预备许多的数据,然后放到那个模型里边去,让它学会“感知+判别+思想”的才干。在深度学习下面,会有咱们常常听到的算法,比如CNN、RNN等。

3 CNN

在机器学习方面有两个方面需求去了解:练习和揣度。榜首是若在云端,叫练习,云端需求有巨大的数据量做练习;第二是设备端。设备端主要是做揣度,即把云端练习好的模型思想办法下载到设备端,设备端再依据取得的信号得出一个揣度的成果。

练习需求许多的数据,需求十分高的功用、许多的带宽去完结。所以一般要在服务器、GPU、加速卡上运转。

在设备端,由于已经有现成的练习模型,所以只做判别/揣度,相对来讲要考虑的当地较为简略,例如功用方面,中低端的功用就可完结;功率方面,包含本钱功率、功耗功率;再有,由于设备端涉及到联网,还要有安全隐私的考虑。

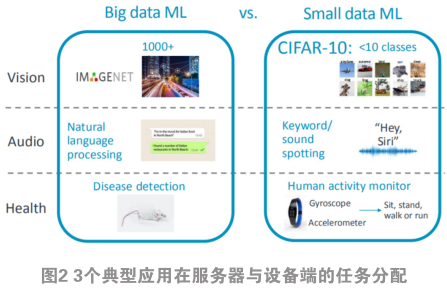

那么,哪些功用合适放在设备端或服务器端/云端?如图2,分别从AI的3个典型运用——视觉、音频以及健康办理来剖析。图2左都是大型的机器学习,在服务器上面,图2右是设备端能够完结的运用与技能。

以视觉来看,首要,假如做详细物体的辨认,例如,这是一条狗,这条是什么品种的狗,或许人脸辨认,这种办法基本上放在服务器端。假如做类的辨认,例如是狗、车仍是飞机,这种辨认就能够放在设备端了。CIFAR-10便是一种常用来做的规范模型。

例如在音频方面,假如仅仅做一个关键字的辨认,或简略的一个指令的辨认,能够放在设备端;假如是做语义的辨认(例如你讲一句话,让机器知道你的意思,答复你下一句话),一般放在云端/服务器端。

相同,在健康办理方面,假如让手机、手环或智能手表做一个动作的辨认,例如解说你是在走路、跑步仍是蹲下,这可在设备端完结;假如要是做详细的疾病辨认,要放在服务器端完结。

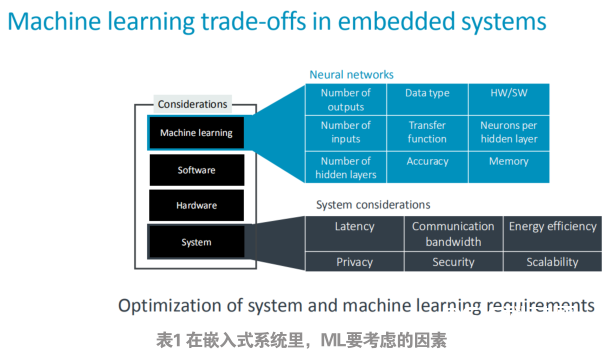

在嵌入式体系里边,做ML要考虑哪些因素?列表如表1所示。

首要在体系层,你要考虑到功率,由于嵌入式设备一般都会有本钱的考虑,由于量十分大,布设的端点十分多。别的是功耗的考虑,有的设备涉及到电池供电。之后还有带宽,由于需求跟服务器/云去通讯。最终还需求考虑到隐私和加密。

在AI部分,或许你要考虑到的你输入的品种、参数、转化的功率、你要得到成果的精度、你所选用的设备的算法,或许你要到达这样精度要耗费的内存资源。

在ML部分常常听到一些算法,比如CNN、DNN、RNN、LSTN。这些算法对应的常用的运用场景,例如CNN合适视觉辨认、图片辨认,DNN比较合适语音辨认。

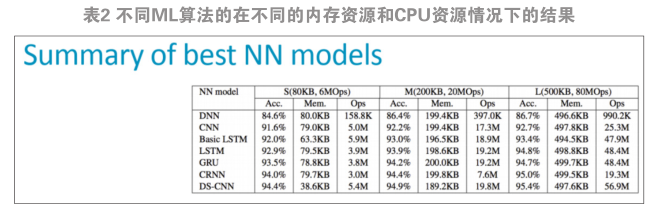

表2是Arm做的不同ML算法在不同的内存资源和CPU资源情况下得到的成果。

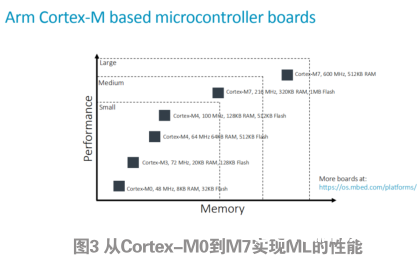

可见准确度、耗费的资源跟你的体系呈对应联系。例如涣散式CNN算法能够到达95%的准确度,最小的时分或许只占了不到40 kB内存,耗费的CPU运算才干只要5.4MOps,这相当于人们常见的M0嵌入式设备就能运转起来。可见,在Arm生态体系里,从M0到M7,都能够在这些芯片上面去完结ML功用(如图3)。这推翻了人们曾经的观念——必定要有很大的GPU、服务器、手机渠道等去做。

在硬件方面,Arm推进MCU芯片合作伙伴,加外设、加功用去做详细芯片出来。相同,在软件方面,Arm也供给了软件中心件,叫。

4 CMSIS-NN

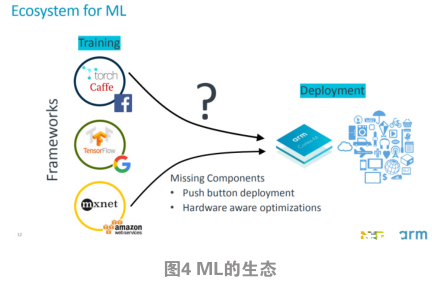

该软件中心件的一个起点是全球比较大的一些公司,包含国内的百度、阿里等常常无偿地供给机器学习的算法,让免费运用,以在其服务器上得到接口。但落地时分怎么办?由于不同公司会供给不同品种的算法,假如你对每种算法都去做支撑,整个开发保护的工作量会十分大的,特别关于嵌入式设备的厂家更是如此。

Arm在中心做了一个规范化的接口优化。上面直接去对接算法,下面去对接详细的硬件。这就把AI机器学习作为是一个曾经的通讯库,或许是API来用,就能够了。图4是详细运用的流程。

CMSIS-NN在Cortex-M上来完结的软件库,是在2018年1月发布的,是开源的,你能够看到一切源代码,因而不会存在安全、自主可控的困惑。

不仅如此,现在NN 还 针 对 大 核 , 例 如系列以及Mali GPU,也是开源的,于2018年年中发布。

至此,CMSIS-NN能够运转在Arm一切CPU上。

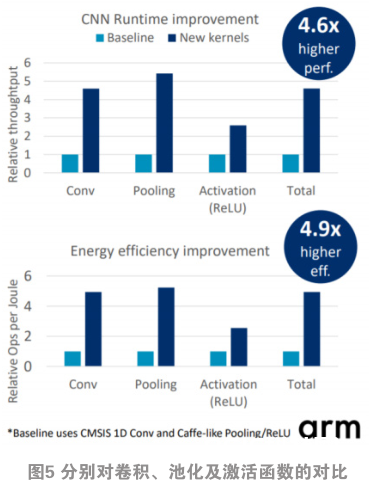

比较只从那些算法公司下载开源程序、把它移植到Arm CPU上去运转,分别对卷积、池化以及激活函数方面做比照,比照图如图5。可见在池化时,用CMSIS-NN,能够到达4.6倍功用的提高。

CMSIS-NN功率很高。恩智浦半导体做的一个在相同的硬件环境下,CMSIS-NN与的功用比照。选用的芯片分别是Cortex-M4和的 芯 片 , 在 做 C I F A R – 1 0 时 ,(注:供给的嵌入式版别的CNN模型)用约120 ms才干完结某个辨认;只需求20 ms左右。

CMSIS-NN一直在更新,基本上每个季度有优化版。

5 用CMSIS-NN做ML的运用事例

榜首个运用是CMSIS-NN怎么与恩智浦半导体的AI渠道——eIQ渠道对接(如图6)。它是把算法集成好,对用户来讲,首要是找到一个事前做好的模型,挑选是否也需求做紧缩的算法。假如不做紧缩,就把它做模型转化到Cortex-M系列里的言语里。只需求把传感器的信号输入,恩智浦的芯片(例如:i.MX RT)就会做出一个决议计划。

实际上,用Arm MCU芯片做成的产品已有商用化的事例。美国的Amiko公司做的哮喘医治器(如图7)选用ML算法来做监测、计算。它的原理比较简略,其间的传感器能够辨认几个内容。榜首,把设备从正常的状况倒置过来,变成放到嘴里的状况。其次,它能够监测到吸入的流量巨细。完结办法是:在云端做好了一个模型之后,它能够经过这模型来辅导这个吸入哮喘剂是否正确,以及吸的量够不够。

本文来源于科技期刊《电子产品世界》2019年第10期第87页,欢迎您写论文时引证,并注明出处。