对人工智能范畴来说,2016年是值得纪念的一年。不只核算机「学」得更多更快了,咱们也 懂得了怎样改善核算机体系。一切都在步入正轨,因而,咱们正目击着史无前例的严重前进:咱们有了能用图片来讲故事的程序,有了无人驾驶轿车,乃至有了能够 发明艺术的程序。假如你想要了解2016年的更多开展,请必定要读一读这篇文章。AI技能已逐渐成为许多技能的中心,所以,了解一些常用术语和作业原理成为了一件很重要的事。

人工智能是什么?

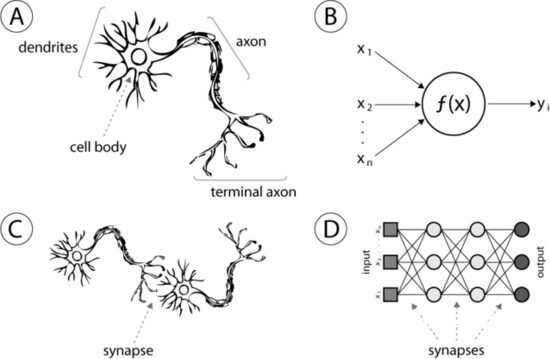

人工智能的许多前进都是新的核算模型,其间绝大多数来自于一项称作「人工神经网络」(artificial neural networks)的技能,简称ANN。这种技能非常粗略地模拟了人脑的结构。值得注意的是,人工神经网络和神经网络是不同的。许多人为了便利起见而把 「人工神经网络」中的人工二字省掉掉,这是不精确的,因为运用「人工」这个词正是为了与核算神经生物学中的神经网络相差异。以下便是实在的神经元和神经突 触。

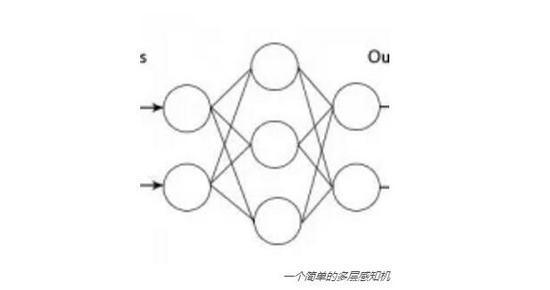

我 们的ANN中有称作「神经元」的核算单元。这些人工神经元经过「突触」衔接,这儿的「突触」指的是权重值。这意味着,给定一个数字,一个神经元将履行某种 核算(例如一个sigmoid函数),然后核算成果会被乘上一个权重。假如你的神经网络只要一层,那么加权后的成果便是该神经网络的输出值。或许,你也可 以装备多层神经元,这便是深度学习的根底概念。

它们来源何处?

人工神经网络不是一个新概念。事实上,它们曩昔的姓名不叫神经网络,它们最早的状况和咱们今日所看到的也彻底不相同。20世纪60时代,咱们把它称之为感知 机(perceptron),是由McCulloch-Pitts神经元组成。咱们乃至还有了误差感知机。终究,人们开端发明多层感知机,也便是咱们今日 一般听到的人工神经网络。

假如神经网络开端于20世纪60时代,那为什么它们直到今日才流行起来?这是个很长的故事,简略来说,有一些原因阻止了ANN的开展。比方,咱们曩昔的核算 才能不行,没有足够多的数据去练习这些模型。运用神经网络会很不舒畅,因为它们的体现好像很随意。但上面所说的每一个要素都在改变。现在,咱们的核算机变 得更快更强壮,而且因为互联网的开展,咱们可运用的数据多种多样。

它们是怎样作业的?

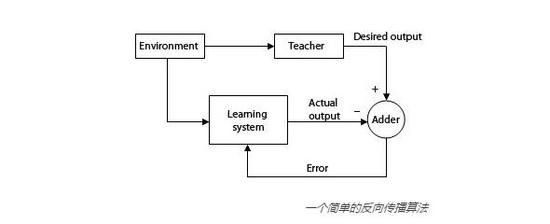

上面我说到了运转核算的神经元和神经突触。你或许会问:「它们怎样学习要履行何种核算?」从实质上说,答案便是咱们需求问它们很多的问题,并提供应它们答 案。这叫做有监督学习。借助于足够多的「问题-答案」事例,储存在每个神经元和神经突触中的核算和权值就能渐渐进行调整。一般,这是经过一个叫做反向传达 (backpropagation)的进程完成的。

幻想一下,你在沿着人行道行走时看到了一个灯柱,但你曾经从未见过它,因而你或许会不小心撞到它并「哎呦」惨叫一声。下一次,你会在这个灯柱周围几英寸的间隔 仓促而过,你的膀子或许会碰到它,你再次「哎呦」一声。直到第三次看到这个灯柱,你会远远地躲开它,以保证彻底不会碰到它。但此刻意外发生了,你在躲开灯 柱的一起却撞到了一个邮箱,但你曾经从未见过这个邮箱,你径直撞向它——「灯柱悲惨剧」的全进程又重现了。这个比如有些过度简化,但这实践上便是反向传达的 作业原理。一个人工神经网络被赋予多个相似事例,然后它试着得出与事例答案相同的答案。当它的输出成果过错时,这个过错会被从头核算,每个神经元和神经突 触的值会经过人工神经网络反向传达,以备下次核算。此进程需求很多事例。为了实践运用,所需事例的数目或许到达数百万。

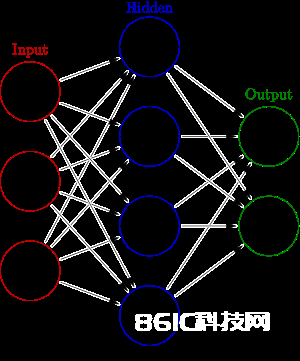

已然咱们了解了人工神经网络以及它们的部分作业原理,咱们或许会想到别的一个问题:咱们怎样知道咱们需求多少神经元?为什么前文要用粗体标出「多层」一词? 其实,每层人工神经网络便是一个神经元的调集。在为ANN输入数据时咱们有输入层,一起还有许多躲藏层,这正是魔法诞生之地。终究,咱们还有输出 层,ANN终究的核算成果放置于此供咱们运用。

一 个层级自身是神经元的调集。在多层感知机的时代,咱们起先以为一个输入层、一个躲藏层和一个输出层就够用了。那时是行得通的。输入几个数字,你仅需求一组 核算,就能得到成果。假如ANN的核算成果不正确,你再往躲藏层上加上更多的神经元就能够了。终究咱们总算了解,这么做其实仅仅在为每个输入和输出发明一 个线性映射。换句话说,咱们了解了,一个特定的输入必定对应着一个特定的输出。咱们只能处理那些此前见过的输入值,没有任何灵活性。这肯定不是咱们想要 的。

现在,深度学习为咱们带来了更多的躲藏层,这是咱们现在获得了更好的ANN的原因之一,因为咱们需求数百个节点和至少几十个层级,这带来了亟需实时追寻的大 量变量。并行程序的前进也使咱们能够运转更大的ANN批量核算。咱们的人工神经网络正变得如此之大,使咱们不能再在整个网络中一起运转一次迭代。咱们需求 对整个网络中的子调集进行批量核算,只要完成了一次迭代,才能够运用反向传达。

有几种类型?

在今日所运用的深度学习中,人工神经网络有许多种不同的结构。典型的ANN中,每个神经元都与下一层的每个神经元相衔接。这叫做前馈人工神经网络(虽然如 此,ANN一般来说都是前馈的)。咱们现已知道,经过将神经元与其他神经元按特定形式相衔接,在处理一些特定情形的问题时,咱们就会得出更好的定论。

1、递归神经网络

递归神经网络(RNN)的规划初衷是为了处理神经网络不能依据曩昔常识做出决议计划的缺点。典型的ANN现已在练习中学会了依据文本做出决议计划,可是一旦它开端为实用做决议计划,这些决议之间便是互相独立的。

一个递归神经网络

为什么咱们会想要这样的东西?好吧,想一想玩21点游戏。假如一开端你得到4和5,你就会知道2以下的牌都不在牌堆中。这种信息会协助你决议是否要拿牌。 RNN在自然言语处理中非常有用,因为前文的字词有助于了解文中其他词语的意义。虽然有不同类型的完成方法,可是意图都是相同的。咱们想要保存信息。为了 到达这一意图,咱们能够经过双向递归神经网络( bi-directional RNN)或履行一个能依据每次前馈来进行调整的递归躲藏层。假如你想学习更多有关RNN的常识,能够查阅这篇博 客:http://karpathy.github.io/2015/05/21/rnn-effectiveness/。

说到这儿,就不得不说到回忆网络( Memory Networks),这一概念是说,假如咱们想要了解比如电影或许书中那些构筑于互相之上的工作时,就必须记住比一个RNN或LSTM(长短期回忆人工神经网络,一种时刻递归神经网络)更多的信息。

Sam走进厨房。

Sam拿起苹果。

Sam走进卧室。

苹果掉到了地上。

问:苹果在哪儿?

答:卧室里。

这是这篇论文(http://arxiv.org/pdf/1503.08895v5.pdf)中的比如。

2、卷积神经网络

卷积神经网络(CNN)有时被称为LeNets(以Yann LeCun命名),是层间随机相连的人工神经网络。但是,以这样的方法设置突触是为了有助于削减需求优化的参数量。经过符号神经元衔接的某种对称性,你能 「从头运用」神经元以得到彻底相同的副本,而不需求平等数量的突触。因为CNN能辨认出周围像素的形式,因而它一般用于图画处理。当你将某一像素与其周围 的像素进行比较时,会包含冗余信息。因为存在对称性,你能够紧缩相似信息。这听起来像是CNN的完美状况,Christopher Olah也有一篇关于了解 CNNs和其他类型的ANNs的优质博客(http://colah.github.io/posts/2014-07-Conv-Nets- Modular/ )。还有一篇关于CNN的博客:http://www.wildml.com/2015/11/understanding- convolutional-neural-networks-for-nlp/ 。

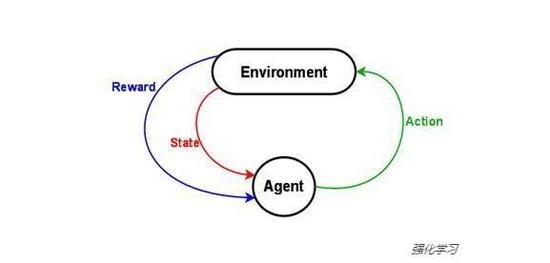

3、强化学习

我想要讨论的终究一种 ANN的类型是强化学习(Reinforcement Learning)。强化学习是一个专业术语,用来描绘核算机在测验将某种报答最大化时所体现出来的行为,这意味着它自身不是一个人工神经网络的结构。然 而,你能用强化学习或遗传算法来构建你曾经从没想过要用的人工神经网络结构。 YouTube用户SethBling上传的用强化学习体系来构建能够自己玩Mario游戏的人工神经网络的视频便是个很好的比如。

另一个强化学习的比如是DeepMind公司的视频中展现的能教程序玩各种Atari游戏。

定论

现在,你应该对现在最先进的人工智能有了必定的了解。神经网络正在驱动你能想到的简直一切工作,包含言语翻译、动物辨认、图片捕捉、文本摘要等等。在未来,你将越来越多地听到它的姓名。