重复数据删去技能使数据归档时尽可能紧凑、简练,不只节省了存储空间,削减了企业本钱,还能够下降能源消耗。

因为二级存储卷的不断添加,企业需求一种办法能够极大地削减数据卷。而许多法律法规的改动,也使得企业面临更大的应战,被逼不得不改动他们原有的数据维护方法。经过重复数据删去,使数据归档时尽可能紧凑、简练,不只极大地削减企业本钱,一起企业还能够将更多的数据在线保存更长时刻。许多企业都期望将数据存储环境的本钱效益和功用发挥到最优,而重复数据删去正是这样一种技能,因而很快招引了企业IT主管的眼球。

人们对物理转移磁带的方法所面临的危险(损坏、被窃、丢掉等)早已十分明晰,而企业在进行长途存储时又特别注重要害信息的维护和危险最小化的问题,电子化传输无疑成为长途传送的最佳挑选。在将备份数据以电子传输方法传送到长途站点进行归档时,重复数据删去能够使所需的带宽需求最小化。

当用户在评价重复数据删去处理方案时,能够将下面的八条规范作为首要评价规范。

能处理要害性问题:有用删去重复数据

重复数据删去处理方案是否能够真实处理要害问题所在:有用的删去二级存储上的重复数据,是咱们首先要考虑的问题。重复的备份数据会形成屡次贮存需求,只需重复数据不被删去,贮存需求就会继续。

ESG集团2007年发布的陈述用图表方法说明晰备份向新技能开展的必要性。相关于一次全备份来说,增量和差异数据备份也能够削减备份的数据量。

但是,即使是增量备份,在维护根据文件级改动的数据时,仍是会备份许多重复的数据。当需求跨过多个站点的多台服务器进行备份时,经过布置重复数据删去处理方案削减存储才是更好的挑选。

能够与当时环境相整合

一个高效的重复数据删去处理方案应该对当时IT环境的影响/中止越小越好。许多企业都挑选运用VTL备份来防止影响/中止,以在不改动企业当时备份战略、处理或软件的状况下提高备份质量。因而,根据VTL的重复数据删去技能在布置时对环境影响也应该是最小的。它将更多的注意力会集在了备份这个巨大的重复数据存储池上。

根据VTL的重复数据删去处理方案一般要求运用专用设备,但这并不影响布置的灵敏性。一个充沛灵敏的重复数据删去处理方案应该是既能够以软件包方法供给给用户,也能够供给给用户全体的处理方案(Turnkey Appliance),然后最大极限地运用户的现有资源得以运用。

VTL容量

假如重复数据删去技能的布置是围绕着VTL进行的,那么VTL本身的容量就有必要作为评价的一部分来考虑。重复数据删去节省下的容量是不能处理因为运用不行规范的VTL所引发的问题的。因而,既要全面考虑VTL的功用性、功用、稳定性以及支撑才能也要充沛考虑重复数据删去的扩展才能。

重复数据删去对备份功用的影响

在哪里、什么时分进行重复数据删去是关系到备份处理功用的十分重要的问题。有些处理方案企图在数据进行备份时删去重复数据,这会使VTL的功用下降多达60%以上,直接形成备份进程太慢和备份窗口太大的严峻功用影响。

比较之下,在备份使命完结之后进行重复数据删去的处理方案则不会呈现这些问题,并且不会对备份功用带来任何影响。别的,为了最大极限的发挥易管理性,处理方案答使用户依照多种不同的要素,如资源运用、出产进展、创立时刻等进行精密(磁带级或磁带组级)的根据战略的重复数据删去。这使得存储经济性轻松完成,一起,也将体系资源的运用发挥到最大。

具有可扩展才能

因为重复数据删去处理方案是用于长时刻的数据贮存的,在容量和功用方面的可扩展才能也是十分重要的考虑要素,并且至少要考虑未来五年乃至更长时刻的添加方案。那么,在确保快速拜访的前提下,你期望有多少数据保存在磁带上?你需求怎样的数据索引体系呢?

优异的重复数据删去处理方案供给的架构,无论是在初始布置时,仍是面临未来体系的长时刻添加,都应该能确保最优化(Right-sizing)、最经济的架构规划。集群能够协助用户满意不断添加的容量需求——即使是N多Petabyte数据添加的环境——并且不会下降重复数据删去的功率或体系的功用。

这个架构还为存储库维护的部分供给了毛病切换(Failover)功用。

支撑分布式使用

重复数据删去技能,不只是能为单个数据中心带来利益,关于具有多个分支组织或多个站点的大型企业来说,它能够让整个企业的分布式使用获益无量。一个包含仿制和多级重复数据删去的处理方案能够将这一技能的优势发挥到极致。

举例来说,一个企业由1个总部和3个区域代表组织构成,能够在区域代表组织布置一台具有重复数据删去功用的容灾设备,使本地存储及向长途中心站点的仿制更为高效。这种处理方案使数据仿制到中心站点的带宽需求降到最低,它只不过是用来确认长途的数据是否现已包含在中心的存储库中。一切站点中,只要仅有的数据会被仿制到中心站点或是容灾站点,不然所需的带宽就会增大。

能够对存储库供给实时维护

确保对删去重复数据的存储库的拜访是十分要害的,因而它不能答应有单点毛病产生。一个优异的重复数据删去处理方案应该包含能够在本地存储毛病产生时供给维护的镜像功用,一起也应该具有仿制功用以在灾祸产生时供给维护。这种处理方案还应该在呈现节点毛病时具有毛病切换才能,即使是一个集群中的多个节点呈现毛病,企业也有必要能够及时康复数据,一起还要确保事务继续运营。

功率及有用性

与根据文件的重复数据删去方法比较,在SUBFILE或数据块级剖析数据的方法删去的冗余数据会更多。比方,一个4MB巨细的文件被修改了一行内容,假如是文件级处理方案,整个4MB的文件都有必要再被保存,而存储上就需求保存两遍。假如这个文件被发送给多个人(这种状况十分遍及),这种负面的效应也会随之倍增。

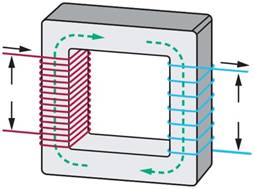

大多数SUBFILE重复数据删去处理是经过将很多的数据切割成“块”,就像虚拟磁带匣相同,在相对小尺度的数据块中查找重复数据。切割成大块的数据处理速度更快,但发现的重复数据也比较少;而切割成小块的数据能够更轻松地发现更多重复数据,但它在扫描数据时所需的开支也会更高。

假如数据在磁带(或其他使用的数据流)的时分就被切割成“块”,重复数据删去处理在备份软件创立的元数据上就能进行。优异的处理方案能够别离元数据,然后在切割成“块”的实践数据文件中发现重复数据,这种方法使找到重复数据的机率更高。有些重复数据删去处理方案乃至能够依照所把握的数据格式来调理切割的“块”的巨细。假如能将这些技能结合使用,将使发现的重复数据数量大幅添加。这在重复数据删去处理方案的经济效益规范方面影响严重。